人类一败涂地!OpenAI血虐《Dota2》半职业战队

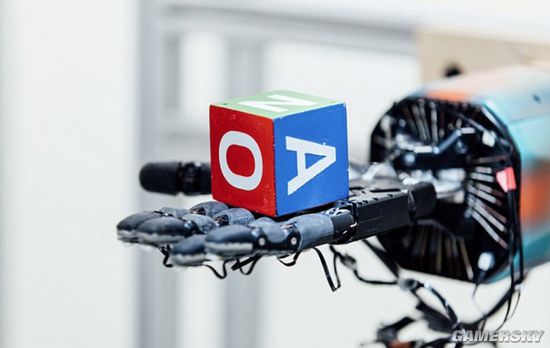

在刚刚秀完可以像人手一样抓取和操纵物体的Dactyl 机械手系统之后,OpenAI迎来又一次令人瞩目的人机大战。

这是家在2015年由马斯克等诸多硅谷大亨联合建立的AI非营利组织,希望能够预防人工智能的灾难性影响,推动人工智能发挥积极作用,当然,他们还希望对标谷歌DeepMind。

北京时间今天凌晨,人类和OpenAI Five展开决战,人类代表队是由半职业Dota高手组成的战队,赛制为三局两胜。经过三轮的对决,高下立判而且毫无悬念,OpenAI Five轻松赢下头两盘,将人类虐的一点脾气都没有。

在第三轮,面对已经锁定胜局的OpenAI Five,主办方让现场观众为OpenAI Five选择英雄,AI阵容是小鱼人、隐刺、 斧王、 流浪、 痛苦之源;人类阵容是死亡先知、死灵法师、巫魔巫师、巫妖、直升机,最后人类高爆发秒人流,才让人类战队稍稍挽回颜面。

最终,比分2:1,人类完败。目前OpenAI Five的水平至少是6600以上。

谈谈为什么AI研究人员如此着迷于游戏

《Dota 2》需要玩家有快速的反应能力以及对游戏的策略有全面的了解,最重要的是,需要团队合作。该游戏是目前最赚钱的电子竞技项目之一,今年规模最大的一项锦标赛奖金池已经超过2300万美元。

研究人员的软件要战胜那些职业电竞选手,难度不亚于让一个机器人隔扣“篮球之神”迈克尔·乔丹(Michael Jordan)。

对于我们这些没有博士学位的人来说,游戏是一种相对简单的了解人工智能研究进展的方式:在复杂的环境中,人工智能能打败人类吗?我们理解IBM的DeepBlue在国际象棋比赛中击败大师级棋手加里·卡斯帕罗夫(Garry Kasparov)意味着什么,也知道谷歌DeepMind的AlphaGo在围棋比赛中战胜世界冠军李世石(Lee Sedol)意味着什么——实践和打磨技术数十载的人类敌不过机械性的计算系统。除了这些公开的比赛之外,人工智能研究人员数十年来一直在致力于打造比人类更会玩雅达利游戏、跳棋甚至《任天堂明星大乱斗》(Super Smash Bros)的人工智能系统。

并不是所有的关于玩电子游戏的AI的研究成果都适用于实验室之外地方,但在竞技场以外,OpenAI正在证明它专有的研究成果能够被广泛应用。举一个例子:被用来参加《Dota 2》比赛的算法,也可以被教导如何移动机械手。

强化学习技术

最热门的用来教导机器人玩游戏的方法之一,也就是OpenAI所使用的技术,名为强化学习,该技术的运作原理是:你给机器人一个目标,比如收集硬币,当机器人完成目标时给予它奖励。最初,机器人是任意行动的,直至它偶然地弄明白了该如何完成任务。机器人用来完成任务的动作被其系统认为是较好的方法,因而当下一次尝试完成任务时,机器人更有可能继续采用那些动作。经过成百上千甚至上百万次的尝试以后,策略就会形成。

例如,OpenAI玩《Dota 2》的机器人在两周内与自己进行数百万次的游戏对抗。在每一场比赛中,机器人的奖励都从为自己获得分数转变成到增加整个团队的分数。该研究小组称这是“团队精神”。

纽约大学人工智能教授朱利安·格里乌斯(Julian Togelius)告诉Quartz:游戏对于人工智能来说是一个很好的学习途径,因为它们模拟现实世界,但带有任务目标。

更多相关资讯请关注:Dota2专区

-

今日,《Dota2》官网更新了2018年不朽物品宝藏III的内容,痛苦女王和巫医拥有了极其稀有物品。2018-08-01 08:08:360

-

OpenAI团队公布了他们的最新成果,AI已经在5V5的比赛中,正式击败了排名前1%的非职业玩家。2018-06-26 12:06:260

-

在《Dota2》PGL布加勒斯特Major比赛的时候,有一个关于Newbee的超魔性“香水广告”的宣传片。大家可以先感受一下。2018-05-17 17:05:240

-

《Dota2》TI8勇士令状不久前正式发售,而在升级本子时玩家可以获得各种有趣的嘲讽动作。2018-05-10 17:05:570

-

3月底的时候,DPL中国DOTA2职业联赛•甲级联赛上爆出假赛丑闻,时间过去还不到半个月,就在今天下午的DSPL次级联赛上,再次出现了疑似假赛事件。2018-04-10 16:04:210

-

时隔多年之后,千呼万唤的屠夫至宝终于公布,《Dota2》官博公布消息,今天的更新中帕吉至宝——千劫神屠上架,屠夫获得了一套全新刀具。拥有全新的自定义动作和特效,包括多种肢解动作、肉钩连中计数、数百条新语音等等——千劫神屠让帕吉有了全新的方法将他的钩子打入战场上2018-04-04 09:04:270

-

BBC电视三台在今天公布了一部名叫《Just Boys》的纪录片,讲述了5名男孩儿结伴欧洲旅行的故事。而故事的主角,则是5名《Dota2》玩家。2018-03-15 12:03:030

-

昨晚举行的《Dota2》布加勒斯特Major小组赛瑞士轮第三轮高分组,VGJ对阵TNC,上演了惊天大翻盘。VGJ飞机最后上演三圣剑,输出爆表。2018-03-07 11:03:360

-

油管UP主“mid or meepo”今天发布了一则视频,展示了《Dota2》当中一个有趣的bug:水人可以通过变形的bug叠加无限攻击力,达到惊人的效果,一起来看看这位up主的演示。2018-01-03 13:01:110

-

随着卡普空的又一冷饭《大神:绝景版》即将于12月12日发售,他们进行了一波非常有意思的联动宣传。2017-12-05 13:12:340

-

俄罗斯Coser Alice Spiegel在今年的震中杯现场带来了新的痛苦女王Cos,冷艳性感的她艳压全场,吸引了不少玩家纷纷与其合影留念。2018-05-07 12:05:230

-

来自俄罗斯的Coser“Catie”在Facebook上晒出了她的《Dota2》米拉娜COS作品,这组cosplay作品不仅衣饰、道具颇为精致,而且Coser本人还牵着一只白虎出镜,可以说是非常还原了。2018-05-05 09:05:000

-

此前Gosu.AI网站带来了所有《Dota2》作弊者比例最高的服务器地区排名,而高居第一的是俄罗斯,日本和欧洲服务器紧随其后。2018-04-12 17:04:340

-

贴吧一名网友发布了几张像素风格《Dota2》英雄画作,看起来非常清新脱俗,而且显得很有立体感。2017-02-08 20:02:260

-

国外玩家Andrey Nick是一个名忠实的Dota粉丝,他不仅热爱《Dota2》的游戏世界,甚至还会用灵巧的双手打造Dota2中的游戏装备道具。2017-01-23 11:01:380

-

《DOTA2》秋季赛淘汰赛正式开打,首轮比赛两支中国队IG.V及Wings分别对抗VP及EG战队,然而却相继遭到了淘汰。2016-12-08 10:12:490

-

近日,斗鱼dota2官方微博整理了一部分越南人民的“绝佳”《Dota2》Cos,各个想象力十足,令人叹服。2016-11-08 15:11:340

-

随着Wings夺得TI6冠军,显然又将掀起一波《Dota2》的游戏热潮,Valve商店近日推出了一款《Dota2》白虎的限量版手办。2016-08-16 17:08:320

-

林俊杰出现在了TI现场与中国冠军战队Wings队员一起合影庆祝夺冠。2016-08-14 22:08:220

-

每届国际邀请赛期间,玩家都可以通过神秘商店购买周边产品。目前Ti6的神秘商店还没有开启,今日,在Reddit论坛上,有玩家曝出了今年神秘商店的毛绒玩具。2016-07-23 15:07:020

-

你好像片里无能的妻子 肉体出轨不敌火车出轨的囧图

你好像片里无能的妻子 肉体出轨不敌火车出轨的囧图

《三男一狗》3主角DLC集齐!集体变老 只有他变年轻

《三男一狗》3主角DLC集齐!集体变老 只有他变年轻

-

索尼:本月港服PS会免价值1420港币!你觉得值吗?

索尼:本月港服PS会免价值1420港币!你觉得值吗?

《守望先锋》全新中国地图公布:这大学是985还是211?

《守望先锋》全新中国地图公布:这大学是985还是211?

-

国产新作遭部分群体抵制!只因疑似制作人玩过黑神话

国产新作遭部分群体抵制!只因疑似制作人玩过黑神话

圣诞季最大黑马!这台神秘游戏主机卖得比PS5还好

圣诞季最大黑马!这台神秘游戏主机卖得比PS5还好

- 老隐形女:《神奇四侠》的裸戏曾让我感到"极度羞辱"

- 榜一大哥崩溃了!曝抖音直播将禁止过度美颜 官方回应

- 网飞官宣827亿美元收购华纳!游戏工作室也拿到手

- 国产抗日FPS新作预告!7位主角16场真实战役

- 《全面战争:中世纪3》公布!已进入早期开发阶段

- 妻子回应朱孝天被退出F4:他曾为合体一个月瘦了30斤

- 《神鬼寓言4》女主被爆改成美女!丰满好身材

- LGBT大作《龙腾世纪4》口碑崩塌暴死 周年庆直接取消

- 韩援Yasal最新美照:白嫩大雷打上黑色印记 太吸睛了!

- 向华强说这辈子唯一捧不起来的演员是向佐:白砸几个亿

- 《Hidden Cats in Spooky Town》官方正版下载

- 《百阳师》官方中文版下载

- 《万言堂代笔工房》官方中文版下载

- 《唱舞星计划》官方中文版下载

- 《数码宝贝世界:Next Order》官方正版下载

- 《银河文明4》官方中文版下载

- 《月球任务》官方中文版下载

- 《机甲战士5:氏族》官方中文版下载

-

发布时间:2025-12-06

-

发布时间:2025-12-05

-

发布时间:2025-12-05